#IJCAI2025 bài báo xuất sắc: Kết hợp MORL với các ràng buộc để học hành vi chuẩn mực - Robohub

Nguồn: robohub

Ngày đăng: 4/9/2025

Để đọc nội dung đầy đủ, vui lòng truy cập vào bài viết gốc.

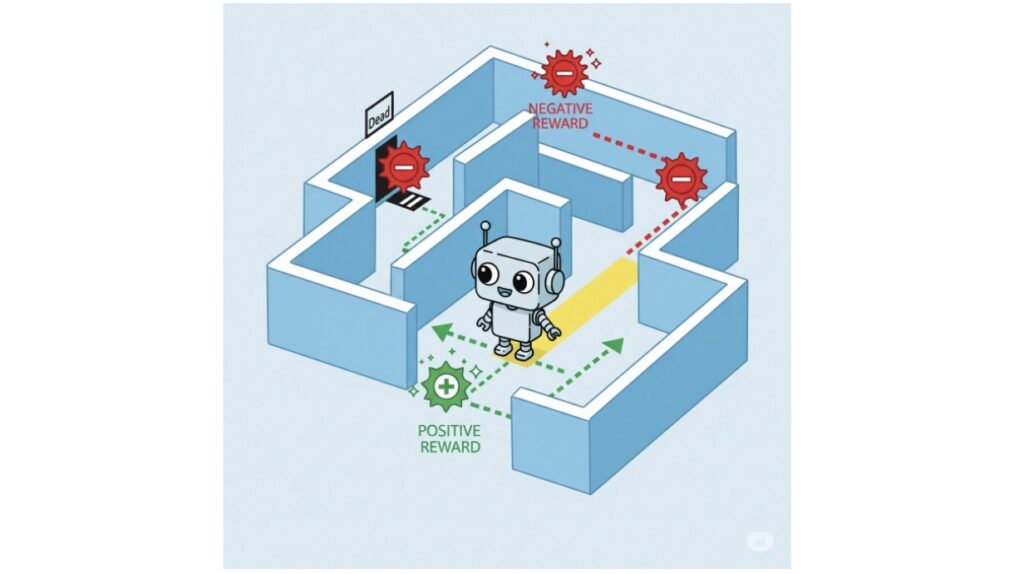

Đọc bài viết gốcBài viết thảo luận về những tiến bộ được trình bày tại IJCAI 2025 liên quan đến việc tích hợp Học Tăng cường Đa Mục tiêu (MORL) với các giới hạn kiểm soát nhằm giúp các tác nhân AI học hành vi chuẩn mực. Các tác nhân tự động, được hỗ trợ bởi học tăng cường (RL), ngày càng được triển khai trong các ứng dụng thực tế như xe tự lái và quy hoạch đô thị thông minh. Trong khi các tác nhân RL xuất sắc trong việc tối ưu hóa hành vi để đạt phần thưởng tối đa, việc tối ưu hóa không giới hạn có thể dẫn đến các hành động mặc dù hiệu quả nhưng có thể không an toàn hoặc không phù hợp với xã hội. Để giải quyết vấn đề an toàn, các phương pháp hình thức như logic thời gian tuyến tính (LTL) đã được sử dụng để áp đặt các ràng buộc đảm bảo các tác nhân hành động trong phạm vi các tham số an toàn đã định nghĩa.

Tuy nhiên, các ràng buộc an toàn đơn thuần không đủ khi các hệ thống AI tương tác chặt chẽ với con người, vì hành vi chuẩn mực liên quan đến việc tuân thủ các chuẩn mực xã hội, pháp lý và đạo đức vượt ra ngoài chỉ sự an toàn. Các chuẩn mực được biểu đạt thông qua các khái niệm deontic — nghĩa vụ, quyền hạn và cấm đoán — mô tả hành vi lý tưởng hoặc chấp nhận được thay vì các sự thật thực tế. Điều này tạo ra sự phức tạp trong việc suy luận, đặc biệt với các trường hợp trái với nghĩa vụ...

Thẻ

robotartificial-intelligencereinforcement-learningautonomous-agentssafe-AImachine-learningnormative-behavior